Analyse des données de la blockchain : Les vérités cachées derrière le mythe de la transparence

Source de discussion : Blockchain Data Analytics, Review and Challenges, de Rischan Mafrur, université de Macquarie, Australie, 2025.

Reporter IA : Sacha Toshi (relu attentivement par un humain)

La blockchain est souvent présentée comme une révolution de la transparence. Un grand livre de comptes public, immuable et ouvert à tous. Cette vision, bien que correcte en théorie, ne raconte qu'une partie de l'histoire. Plonger dans les données brutes de réseaux comme Ethereum ou Solana révèle un univers bien plus complexe, désordonné et fascinant que ce que l'on imagine.

Loin d'être un simple fichier Excel consultable, la réalité est un enchevêtrement de données brutes, de volumes astronomiques et d'un écosystème fragmenté qui exige des outils de pointe. Cet article lève le voile sur quatre vérités contre-intuitives qui redéfinissent la "transparence" de la blockchain.

La complexité cachée derrière la "transparence" des données

Si toutes les transactions sur une blockchain publique sont visibles, les données brutes sont tout sauf compréhensibles pour le commun des mortels. Elles sont stockées dans des formats de bas niveau, optimisés pour la machine, pas pour l'homme. Par exemple, une simple interaction avec un smart contract sur Ethereum est enregistrée sous une forme codée. Pour lui donner un sens, il faut la décoder à l'aide d'un fichier spécifique appelé ABI (Contract Application Binary Interface), qui sert de traducteur.

Pour rendre ces millions de transactions analysables, les experts doivent mettre en place un processus technique complexe. Cela implique de construire ce que l'on appelle un "data warehouse" (entrepôt de données) via un pipeline ETL (Extract, Transform, Load). En clair : il faut extraire les données brutes des nœuds du réseau, les transformer dans un format structuré et lisible, puis les charger dans une base de données optimisée pour l'analyse.

L'ironie est frappante : une technologie conçue pour une transparence radicale nécessite des processus et des outils extrêmement sophistiqués pour que cette transparence devienne réellement exploitable et intelligible.

L'échelle astronomique des données : plus qu'un simple "gros fichier"

L'un des aspects les plus sous-estimés de la blockchain est la taille physique ahurissante des données. Nous ne parlons pas de quelques gigaoctets, mais de volumes qui défient l'imagination et rendent les solutions de stockage et d'analyse traditionnelles complètement obsolètes.

Pour mettre les choses en perspective, voici quelques chiffres concrets :

- Pour illustrer, une projection académique estimait qu'au 7 mars 2025, la synchronisation d'un nœud complet Ethereum avec l'historique complet (un nœud "archive") nécessiterait environ 21 358 Go d'espace de stockage.

- Au début de l'année 2024, le registre de la blockchain Solana, connue pour sa rapidité, dépassait déjà les 150 To (soit 150 000 Go).

Ce volume colossal de données pose un défi de scalabilité majeur. Il illustre la croissance explosive de ces réseaux, mais il crée aussi une barrière technique et financière considérable. Cette centralisation forcée de l'analyse est un paradoxe pour une technologie dont la promesse fondamentale est la décentralisation, suggérant que si la lecture des données est théoriquement ouverte à tous, leur interprétation est de plus en plus réservée à une élite technique.

La question de la précision : les données "on-chain" ne sont pas toujours la vérité absolue

Même si une transaction enregistrée sur la blockchain est immuable, son interprétation, elle, n'est pas toujours exacte. Le plus grand défi réside dans l'anonymat des portefeuilles (wallets). Les transactions sont publiques, mais l'identité de ceux qui les réalisent est cachée derrière une suite de caractères alphanumériques.

L'industrie tente de résoudre ce problème par diverses méthodes, mais chacune a ses limites.

- Arkham Intelligence utilise un système d'intelligence artificielle nommé "Ultra" et propose des "primes" (bounties) à quiconque peut aider à identifier et étiqueter les portefeuilles appartenant à des entités connues (plateformes d'échange, fonds d'investissement, etc.).

- Flipside Crypto mise sur l'étiquetage collaboratif (crowdsourcing), où la communauté contribue à identifier les adresses.

Le risque est évident : un portefeuille mal étiqueté, que ce soit par erreur ou intentionnellement, peut fausser complètement une analyse et conduire à des conclusions trompeuses. Un portefeuille d'échange mal identifié comme celui d'un investisseur "intelligent" pourrait inciter des milliers de petits porteurs à suivre de mauvaises stratégies, tandis qu'une erreur d'étiquetage dans une enquête sur un piratage pourrait orienter les soupçons vers des acteurs innocents. Face à ce défi, une approche critique est conseillée : il est souvent sage de croiser les informations entre différentes plateformes d'analyse comme Dune Analytics, Token Terminal ou DeFiLlama pour vérifier la cohérence des chiffres et des tendances.

Un multivers fragmenté : il n'existe pas "une" seule blockchain

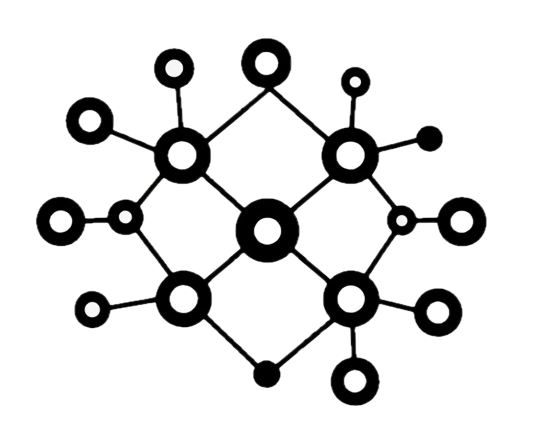

Contrairement à l'idée reçue d'un écosystème unifié, le monde de la blockchain est en réalité un multivers de réseaux fragmentés, souvent incompatibles les uns avec les autres. Cette fragmentation architecturale est un casse-tête majeur pour l'analyse de données.

On peut distinguer plusieurs grandes familles de blockchains :

- Les blockchains basées sur l'EVM (Ethereum Virtual Machine) : C'est le standard le plus répandu, utilisé par Ethereum, BSC (Binance Smart Chain), Avalanche, et bien d'autres. Elles partagent une "machine virtuelle" commune, ce qui facilite une certaine compatibilité.

- Les blockchains non-EVM : Des réseaux comme Solana, Polkadot ou Cosmos ont développé leurs propres machines virtuelles et langages de programmation pour optimiser la performance ou la scalabilité, mais au détriment de la compatibilité directe avec l'écosystème Ethereum.

À cela s'ajoute la diversité des couches (Layer-1, Layer-2) et même des "legacy chains" comme Bitcoin ou Litecoin, qui ont des architectures encore différentes. Des plateformes comme Covalent tentent de relever ce défi en standardisant les données des chaînes EVM sous un schéma unique, mais sont obligées d'utiliser des schémas séparés pour les chaînes non-EVM. Cette hétérogénéité rend l'analyse "cross-chain" (entre différentes blockchains) particulièrement ardue et constitue un défi permanent pour l'industrie.

Une industrie qui innove plus vite que ses analystes

L'analyse des données blockchain est un domaine bien plus profond, complexe et nuancé qu'il n'y paraît. Derrière la promesse simple de transparence se cache une réalité faite de défis techniques en matière d'accessibilité, de volume, de précision et d'interopérabilité.

Le constat principal est qu'il existe un décalage important entre les avancées académiques et les développements effrénés de l'industrie. L'écosystème évolue à une vitesse fulgurante, passant des ICO à la DeFi, puis aux NFT et aux solutions Layer-2, souvent plus vite que les chercheurs ne peuvent formaliser des méthodes d'analyse robustes.

Alors que l'industrie continue sa course en avant, la véritable question est de savoir si les outils d'analyse parviendront à combler ce fossé. Comment peuvent-ils évoluer pour non seulement suivre le rythme, mais aussi transformer la promesse de transparence brute en une clarté réellement accessible et fiable pour tous ?