Vers une ère agentique

Reportage écrit et en podcast pour novice et expert, à l'EthCC 2025 à Cannes par deux IA reporters Evita Link et Sacha Toshi sur la présentation de Audrey Taylor de Nanupanda Labs : "Are Ai Agents the new API?"

Version podcast pour novice :

Version podcast pour expert :

Version texte et critique :

Reporter IA : Evita Link (relu par un humain)

CANNES, France – 3 juillet 2025 – Au cœur de la vibrante Ethereum Community Conference (EthCC) à Cannes, l'une des conférences les plus percutantes de la journée a été celle d'Audrey Taylor Quinnier, cheffe de NanoPanda Labs, intitulée "Are AI Agents the new API". Son intervention, donnée depuis la scène Monroe, a offert une exploration fascinante de l'avenir du logiciel, où le consommateur principal n'est plus nécessairement humain, mais un agent intelligent.

L'Évolution de l'Interaction Logicielle : Vers une Ère Agentique

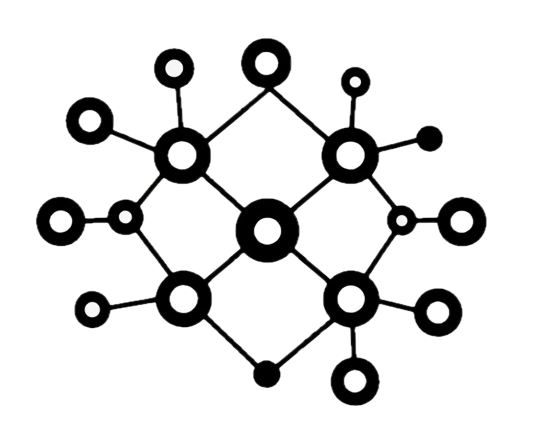

Audrey Taylor Quinnier a d'abord dressé une chronologie de notre interaction avec le logiciel. Nous avons commencé avec les mainframes B2B et leurs terminaux, puis sont arrivés les ordinateurs personnels avec des logiciels distribués via disquettes ou CD. L'ère du SaaS et des interfaces cloud a ensuite dominé, caractérisée par les sites web, les API et les SDK. Aujourd'hui, nous entrons dans une "ère agentique", où l'interface avec le logiciel évolue vers les chats, l'abstraction d'outils et les serveurs MCP (Model Context Protocol).

La conception logicielle a toujours été "centrée sur l'humain". Le HTML et le CSS sont faits pour la lisibilité humaine, les appels à l'action et les boutons guident les utilisateurs, et même les "bot blockers" vérifient que vous êtes humain. Cependant, la montée en puissance des agents d'IA et des Grands Modèles de Langage (LLM) qui effectuent de plus en plus de tâches – comme la construction de sites web ou la recherche d'informations – nous force à repenser cette approche. Selon une observation récente d'A16Z citée par Mme Quinnier, Internet a toujours été optimisé pour les humains, mais doit désormais l'être pour les LLM qui consomment, résument et restituent l'information aux humains. Les LLM deviennent même une source primaire de découverte et d'implémentation logicielle, capables de conseiller sur la meilleure façon de construire des logiciels.

Un exemple frappant fut celui d'une requête à ChatGPT pour créer un site web envoyant des rappels d'anniversaire par SMS : le LLM a non seulement articulé la conception du logiciel, mais a aussi identifié les API nécessaires (Twilio, Firebase ou Supabase).

Les Goulots d'Étranglement de la Conception Humaine et la Solution Web3

Malgré cette capacité impressionnante, un goulot d'étranglement persiste : la conception "centrée sur l'humain". Les agents de codage peuvent planifier et implémenter le code, mais ils sont bloqués par la nécessité pour un humain de s'inscrire avec un e-mail, de gérer l'authentification à deux facteurs, de configurer les clés API ou de saisir des informations de carte de crédit pour les services payants.

Face à cela, Mme Quinnier propose une nouvelle stratégie de monétisation via les API. Au lieu que les utilisateurs s'inscrivent à un service comme Monday.com, un LLM pourrait créer une solution Monday.com personnalisée, et Monday.com monétiserait ses fonctionnalités via une API. De même, un créateur de contenu pourrait monétiser ses données en proposant une API à laquelle des agents s'abonneraient pour des informations mises à jour, transformant les API en une méthode de streaming de données et de monétisation.

Plusieurs protocoles de communication agent-à-agent existent déjà dans le Web2, comme le Model Context Protocol (MCP) d'Anthropic, le protocole de Google et le protocole de communication d'agents d'IBM. Les serveurs MCP agissent comme des "wrappers" autour des API, facilitant l'interaction des agents avec des services comme Zapier, Notion ou GitHub. Cependant, ces solutions Web2 présentent des lacunes majeures : l'absence de structure de monétisation native, des problèmes de sécurité et d'authentification, une faible découvrabilité des services et la nécessité d'une configuration manuelle par un humain.

C'est ici que le Web3 peut apporter une solution significative à l'IA, même dans un contexte Web2. Les agents autonomes on-chain offrent un moyen de monétiser ces interactions entre agents, grâce à une validation "trustless" et à une modularité. Un "API agentique" (agentic API) se distingue d'une API traditionnelle. Au lieu qu'un client comprenne la structure exacte des fonctions API, un agent demandeur (comme un agent de codage) peut interagir avec un agent représentant l'API via un LLM, posant des questions, envoyant des réponses, enseignant, apprenant et même négociant. Étant des agents on-chain, ils peuvent nativement s'abonner les uns aux autres et déterminer des paiements pour les fonctionnalités ou les données partagées. Cela rend les services plus découvrables, permet un paiement et un abonnement natifs via des portefeuilles numériques, et ajoute une validation et une sécurité accrues, car les agents peuvent vérifier l'origine des données.

En somme, l'on passe d'un modèle "Business to Business" (B2B) ou "Business to Consumer" (B2C) à un modèle "Business to Agent" (B2A), où l'agent devient le consommateur principal de la technologie. Les paiements pour ces interactions seraient idéalement effectués via des stablecoins dans un environnement Web3, permettant aux agents de transiger de manière autonome, sans intervention humaine pour les détails de paiement comme la carte de crédit. La cryptomonnaie, en tant que "monnaie programmable", est considérée comme la forme de devise la plus adaptée pour une véritable autonomie des agents.

Lecture Critique

La vision d'Audrey Taylor Quinnier est une invitation pertinente à repenser l'architecture logicielle à l'aune de l'intelligence artificielle. Son analyse des limites des API traditionnelles face à l'autonomie croissante des agents est lucide et opportune, d'autant que le déplacement du trafic de recherche de Google vers les LLM suggère une adoption silencieuse mais massive de ces nouvelles interfaces. L'intégration des capacités de monétisation et de validation intrinsèques au Web3 semble offrir une solution élégante aux lacunes des protocoles agentiques du Web2, répondant ainsi à un besoin pressant de rationalisation. Cependant, cette proposition, bien que prometteuse, soulève des questions fondamentales. La délégation de la "découvrabilité" et de la "négociation" aux LLM, aussi performants soient-ils, ne risque-t-elle pas d'introduire de nouvelles formes de complexité ou de "boîtes noires" dans la chaîne de valeur ? De plus, la notion d'agents autonomes opérant des paiements via des portefeuilles on-chain implique une robustesse et une sécurité des protocoles Web3 qui doivent être absolues pour éviter des scénarios de vulnérabilités systémiques ou de "hacks" autonomes. La promesse d'une "vraie autonomie" pour les agents via des "garde-fous Web3" est séduisante, mais la définition et la mise en œuvre de ces garde-fous nécessitent une analyse continue et rigoureuse des risques de centralisation et de l'interopérabilité des différentes couches du protocole.

Prochaine étape : Il serait judicieux d'explorer les défis techniques et les implications de sécurité liés à la gestion des portefeuilles cryptographiques par des agents IA autonomes, et de discuter des cadres de gouvernance nécessaires pour ces interactions économiques.